Le fichier robots.txt reste l’un des éléments les plus sous-estimés par les TPE et PME, alors qu’il influence directement la visibilité de leur site sur Google. Pourtant, une mauvaise configuration peut bloquer l’indexation de pages stratégiques ou, à l’inverse, laisser les moteurs de recherche explorer des contenus inutiles. Comment adapter votre approche pour éviter les pièges et optimiser votre référencement naturel ? Voici un guide pratique, adapté aux non-techniciens.

Qu’est-ce qu’un fichier robots.txt et pourquoi est-il important pour votre site professionnel ?

Définition et rôle : un « panneau de signalisation » pour les moteurs de recherche

Le fichier robots.txt est un document texte placé à la racine de votre site (ex. : votresite.com/robots.txt). Il indique aux robots des moteurs de recherche quelles pages ils ont le droit d’explorer (User-agent) et quelles zones ils doivent ignorer (Disallow). Contrairement aux idées reçues, il ne bloque pas l’indexation des pages, mais leur accès.

Par exemple, si vous ne souhaitez pas que Google analyse votre espace admin ou vos fichiers PDF internes, ce fichier permet de le spécifier. À noter : il ne remplace pas les mesures de sécurité (comme un mot de passe), car il reste accessible à quiconque connaît son URL.

Les conséquences d’un robots.txt mal configuré pour une PME

Une erreur courante consiste à bloquer accidentellement des pages essentielles, comme la page d’accueil ou les fiches produits. Résultat : ces contenus n’apparaissent plus dans les résultats de recherche, ce qui se traduit par une baisse de trafic et de leads. À l’inverse, un fichier trop permissif peut surcharger votre serveur avec des requêtes inutiles, ralentissant l’expérience utilisateur. Ou encore d’indéxer des PDF sans le vouloir.

Un cas concret ? Une boutique en ligne ayant bloqué son dossier /images/ via Disallow a vu ses visuels disparaître des résultats Google Images, réduisant son taux de clics de 30 %. Pour les PME, l’enjeu est double : éviter les pertes de visibilité tout en optimisant les ressources techniques.

Depuis 2024 : les chôses change dans la gestion des robots.txt

La fin du support des règles « noindex » : quels impacts pour votre stratégie SEO ?

Depuis septembre 2019, Google ignore les directives noindex placées dans le robots.txt. Cette règle s’applique désormais à tous les moteurs de recherche. Pour exclure une page des résultats, il faut désormais utiliser :

- La balise meta < meta name= »robots » content= »noindex »> dans le code HTML de la page,

- Ou un en-tête HTTP X-Robots-Tag: noindex.

Cette évolution vise à clarifier les signaux envoyés aux robots. Pour une PME, cela signifie revoir ses méthodes si elle comptait sur le robots.txt pour masquer des pages obsolètes ou dupliquées.

Google et les autres moteurs : des comportements différents à anticiper

Tous les moteurs ne traitent pas le robots.txt de la même façon. Google respecte généralement les directives, mais Bing ou Yandex peuvent adopter des interprétations plus souples. Par exemple :

- Google cache les pages bloquées par Disallow, mais les conserve en mémoire.

- Bing peut indexer une URL même si son accès est interdit, en se basant sur des liens externes.

Pour les sites internationaux ou ciblant plusieurs moteurs, il est conseillé de combiner le robots.txt avec d’autres méthodes (comme les balises canoniques) pour un contrôle optimal.

Comment créer ou modifier votre fichier robots.txt ? Un guide étape par étape

Où se trouve le fichier et comment y accéder

Le fichier se situe à la racine de votre site, accessible via votredomaine.com/robots.txt. Pour le modifier :

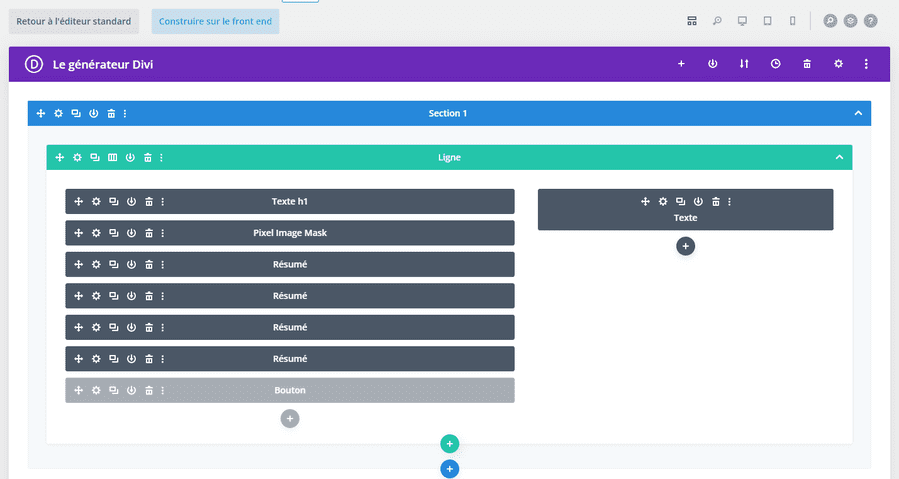

- Si vous utilisez un CMS comme WordPress : installez un plugin dédié (ex. Yoast SEO ou Rank Math) pour l’éditer sans toucher au code.

- Pour un site custom : connectez-vous à votre serveur via FTP (FileZilla) ou l’interface de votre hébergeur (cPanel, Plesk).

Astuce : avant toute modification, sauvegardez une copie du fichier existant pour éviter les erreurs.

La syntaxe de base à maîtriser : 3 commandes essentielles

Un fichier robots.txt minimaliste mais efficace pour une PME peut se limiter à ces lignes :

User-agent: * Disallow: /admin/ Disallow: /search/ Allow: /public/

Explications :

- User-agent: * : s’applique à tous les robots.

- Disallow: /admin/ : bloque l’accès au dossier admin.

- Allow: /public/ : autorise explicitement un dossier (utile si une règle précédente le bloque par erreur).

Pour les sites e-commerce, ajoutez Disallow: /cart/ et Disallow: /checkout/ pour protéger les tunnels de conversion.

Outils gratuits pour générer et tester votre fichier

Plusieurs solutions permettent de vérifier votre syntaxe avant mise en ligne :

- TechnicalSEO.com : simulateur de comportement des robots.

- Google Search Console : onglet « Test du fichier robots.txt » pour détecter les erreurs.

- XML-Sitemaps : validateur en ligne.

Ces outils évitent les fautes de syntaxe (comme un Disallow sans slash final), qui pourraient rendre le fichier inopérant.

Erreurs fréquentes à éviter absolument

Bloquer accidentellement des pages stratégiques

Les sites e-commerce sont particulièrement exposés, avec des règles comme Disallow: /product/ qui bloquent toutes les fiches articles. Pour éviter cela :

- Utilisez des chemins précis (ex. : Disallow: /product/old-collection/).

- Vérifiez l’impact avec Google Search Console avant validation.

Un audit régulier via un expert en optimisation de site web permet de corriger ces erreurs avant qu’elles n’affectent votre trafic.

Les problèmes de formatage qui rendent le fichier illisible

Un robots.txt mal formaté (espaces superflus, majuscules/minuscules incohérentes) peut être ignoré. Respectez ces règles :

- Un seul User-agent par ligne.

- Pas d’espaces avant les commandes (Disallow: et non Disallow:).

- Utilisez des commentaires (préfixés par #) pour documenter vos choix.

Exemple de fichier mal écrit :

user-agent: * # Erreur : minuscule et espace disallow: /temp/ # Erreur : commande en minuscule

Comment vérifier son interprétation via Google Search Console

Dans l’onglet « Indexation » > « Fichier robots.txt », Google affiche :

- Les erreurs de syntaxe détectées.

- Les URLs bloquées par vos règles.

- Les avertissements (ex. : règles redondantes).

Un statut « Autorisé » en vert confirme que le fichier est valide. Sinon, corrigez les lignes signalées en rouge.

Cas pratiques : adapter son robots.txt selon son type de site

Exemple de configuration pour un site vitrine PME

Pour un site institutionnel (5 à 10 pages), ce modèle suffit :

User-agent: * Disallow: /wp-admin/ Disallow: /wp-login/ Allow: /wp-content/uploads/ Sitemap: https://votresite.com/sitemap.xml

À noter :

- Allow: /wp-content/uploads/ autorise l’indexation des images (utile pour le référencement local).

- Sitemap : indique l’emplacement de votre plan de site XML pour faciliter le crawl.

Spécificités pour les boutiques en ligne

Les sites e-commerce doivent gérer :

- Les pages de filtres (ex. : Disallow: /*?orderby=) pour éviter le contenu dupliqué.

- Les pages de panier et de paiement (Disallow: /cart/).

- Les anciennes collections (Disallow: /collections/2023/).

Exemple pour un site sous Symfony (framework PHP) :

User-agent: * Disallow: /admin/ Disallow: /api/ Disallow: /_fragment Allow: /media/cache/

Ici, /media/cache/ est autorisé pour que les images optimisées restent accessibles.

Quand privilégier le robots.txt aux balises meta ou au .htaccess ?

Utilisez le robots.txt pour :

- Bloquer l’accès à des dossiers entiers (ex. : /private/).

- Limiter la charge serveur en restreignant les crawls inutiles.

Préférez les balises meta noindex pour :

- Masquer des pages individuelles (ex. : une ancienne offre).

- Gérer des contenus dynamiques (ex. : résultats de recherche interne).

Le fichier .htaccess (pour Apache) est quant à lui réservé aux restrictions techniques (ex. : blocage par IP).

Quand faire appel à un expert SEO ?

Consultez un professionnel si :

- Votre trafic chute sans explication (vérifiez d’abord le robots.txt !).

- Vous migrez vers un nouveau CMS ou changez de nom de domaine.

- Votre site dépasse 100 pages (la gestion manuelle devient risquée).

Un audit technique identifie les problèmes invisibles, comme des conflits entre robots.txt et balises meta.

Besoin d’un audit technique personnalisé pour votre site ?

Le fichier robots.txt n’est qu’un élément parmi d’autres pour optimiser votre visibilité. Si vous souhaitez un diagnostic complet de votre site (vitesse, indexation, structure), nos experts analysent vos points faibles et proposent des solutions adaptées à votre budget.